In der sich stets weiterentwickelnden Welt der Künstlichen Intelligenz (KI) nimmt das Prompt Engineering eine Schlüsselrolle ein. Es handelt sich dabei um die Kunst und Wissenschaft der Formulierung und Strukturierung von Anfragen oder „Prompts“, die KI-Modelle dazu anleiten, die gewünschten Antworten zu liefern. Ein gut konstruierter Prompt kann den Unterschied ausmachen zwischen einer nützlichen Antwort und einer irrelevanten oder sogar irreführenden Antwort. In diesem Blogpost tauchen wir tief in das Thema des Prompt Engineerings ein und zeigen Ihnen, wie wir bei Coleida verschiedene Frameworks und Methoden nutzen, um Prompts für KI-Modelle zu strukturieren.

Was ist Prompt Engineering?

Prompt Engineering ist ein fundamentaler Aspekt in der Entwicklung und Optimierung von Künstlicher Intelligenz (KI). Es ist die Kunst und Wissenschaft der Formulierung von Anfragen oder „Prompts“, die KI-Modelle dazu veranlassen, die gewünschten Antworten zu liefern

Verstehen der Prompts

Prompts sind Anfragen oder Befehle, die an ein KI-Modell gerichtet sind. Sie sind in der Regel in natürlicher Sprache formuliert und dienen dazu, das KI-Modell dazu zu bringen, bestimmte Aktionen auszuführen oder bestimmte Informationen zu liefern. Ein Prompt könnte so einfach sein wie „Was ist das Wetter heute?“ oder so komplex wie „Analysiere diese Daten und gib eine Zusammenfassung der wichtigsten Trends und Muster. Achte dabei vor allem auf […] und […]. Gib das Ergebnis in folgender Struktur aus: […]“.

Die Bedeutung von Prompt Engineering

Prompt Engineering ist entscheidend, um sicherzustellen, dass KI-Modelle effektiv und präzise arbeiten. Ein gut formulierter Prompt kann dazu beitragen, dass das KI-Modell genau versteht, was von ihm verlangt wird, und die gewünschten Ergebnisse liefert. Auf der anderen Seite kann ein schlecht formulierter oder unklarer Prompt zu ungenauen, irrelevanten oder gar irreführenden und falschen Antworten führen.

Die Rolle des Prompt Engineering in der KI-Entwicklung

In der KI-Entwicklung spielt das Prompt Engineering eine zentrale Rolle. Es hilft dabei, die Interaktionen zwischen Benutzern und KI-Modellen zu steuern und zu optimieren. Durch die Formulierung effektiver Prompts können Entwickler KI-Modelle dazu bringen, relevante und nützliche Antworten zu liefern, die Benutzern helfen, ihre Ziele zu erreichen.

Frameworks für das Prompt Engineering: RACE und COAST

Wir bei Coleida nutzen hauptsächlich zwei Frameworks, um das Prompt Engineering zu strukturieren und zu optimieren: RACE und COAST. Beide bieten eine effektive Struktur zur Spezifizierung der Anforderungen an das KI-Modell und seine Antworten.

RACE Framework

RACE steht für Role (Rolle), Action (Aktion), Context (Kontext) und Expectation (Erwartung). Jeder dieser vier Aspekte spielt eine entscheidende Rolle in der Formulierung eines effektiven Prompts.

- Role (Rolle): Hier definieren wir die Funktion, die das KI-Modell innerhalb eines bestimmten Kontexts oder einer bestimmten Anwendung einnehmen soll. Dies könnte zum Beispiel die Rolle eines Customer Service Representatives in einem Chatbot für Kundenservice sein.

- Action (Aktion): Dies bezieht sich auf die spezifische Aktion oder Aufgabe, die das KI-Modell ausführen soll. In unserem Kundenservice-Chatbot-Beispiel könnte dies das Beantworten von Kundenanfragen oder das Bereitstellen von Informationen zu Produkten oder Dienstleistungen sein.

- Context (Kontext): Dieser Aspekt bezieht sich auf den spezifischen Kontext oder die Situation, in der das KI-Modell agiert. Dies könnte das Kundenservice-Szenario sein, in dem der Chatbot arbeitet, oder sogar spezifischere Kontexte innerhalb dieses Szenarios, wie z.B. die Beantwortung von Fragen zu einem bestimmten Produkt.

- Expectation (Erwartung): Schließlich legt die Erwartung fest, was als erfolgreiches Ergebnis der vom KI-Modell durchgeführten Aktion angesehen wird. Dies könnte eine korrekte und hilfreiche Antwort auf eine Kundenanfrage sein oder eine effektive Weiterleitung des Kunden an den richtigen Ansprechpartner.

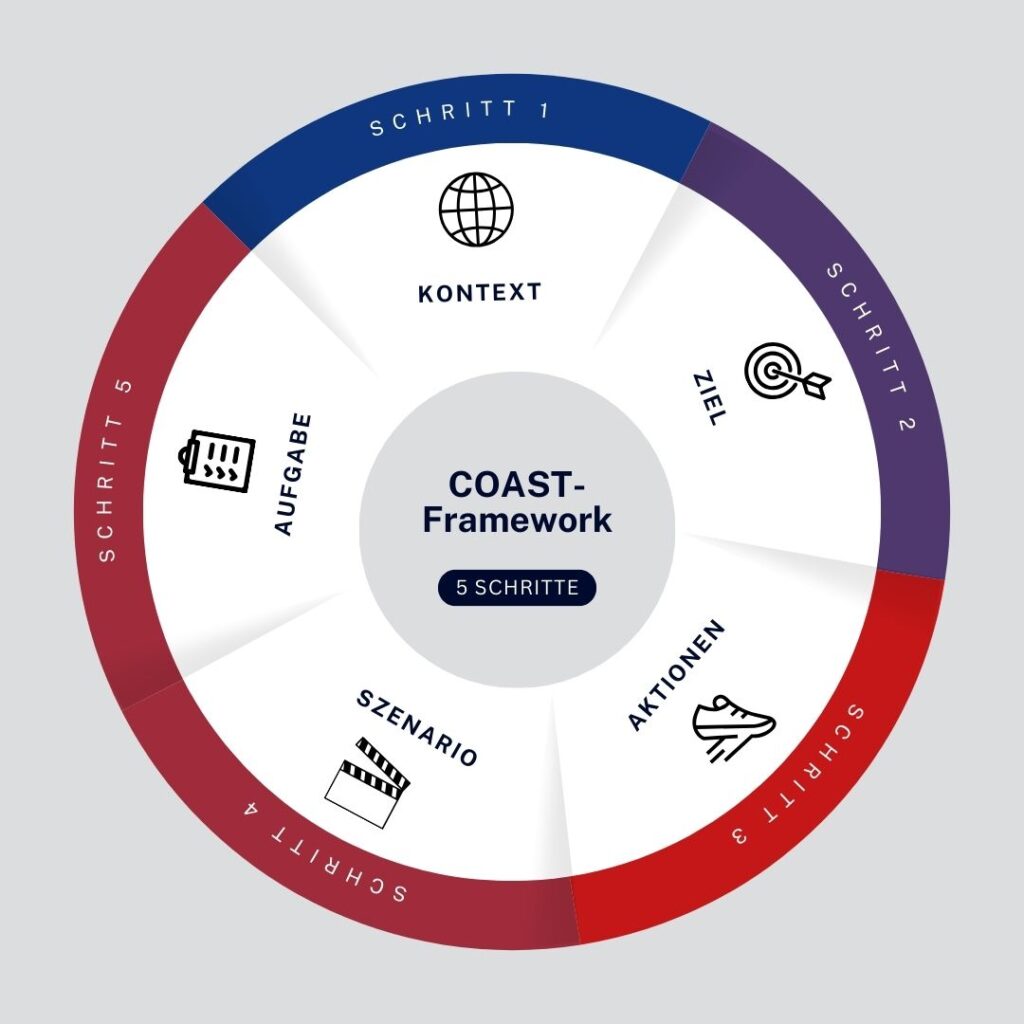

COAST Framework

COAST steht für Context (Kontext), Objective (Ziel), Actions (Aktionen), Scenario (Szenario) und Task (Aufgabe). Wie RACE bietet auch COAST eine effektive Struktur für das Prompt Engineering, legt aber etwas andere Schwerpunkte.

- Context (Kontext): Ähnlich wie bei RACE bezieht sich der Kontext auf den Rahmen oder die Situation, in der das KI-Modell agiert.

- Objective (Ziel): Das Ziel legt das angestrebte Ergebnis der Interaktion mit dem KI-Modell fest. Dies könnte beispielsweise die Lösung eines bestimmten Problems oder die Beantwortung einer bestimmten Frage sein.

- Actions (Aktionen): Die Aktionen sind die spezifischen Schritte, die das KI-Modell unternehmen muss, um das Ziel zu erreichen.

- Scenario (Szenario): Das Szenario stellt eine spezifische Situation oder ein spezifisches Ereignis dar, in dem das KI-Modell agiert. Es hilft dabei, den Kontext und die Ziele weiter zu spezifizieren.

- Task (Aufgabe): Die Aufgabe gibt genaue Anweisungen, was das KI-Modell tun soll. Sie ist in der Regel spezifischer als die Aktionen und kann als eine Art „Unteraufgabe“ innerhalb der Aktionen angesehen werden.

Zusammen bieten RACE und COAST eine umfassende und flexible Struktur für das Prompt Engineering, die es ermöglicht, effektive und präzise Prompts zu erstellen, die KI-Modelle dazu anleiten, die gewünschten Antworten zu liefern. Sie helfen dabei, die Anforderungen und Erwartungen an das KI-Modell klar zu definieren und sicherzustellen, dass das Modell in der Lage ist, in verschiedenen Kontexten und Szenarien effektiv zu agieren.

Die Bedeutung der Systemnachricht

Die Systemnachricht ist ein entscheidendes Element im Prompt Engineering. Es handelt sich dabei um eine Art „Anleitung“ oder „Instruktion“ für das KI-Modell, die es auf den richtigen Pfad zur Lieferung der gewünschten Antworten lenkt. Die Systemnachricht hat die Aufgabe, dem KI-Modell zu erklären, wie es sich verhalten soll, und kann die Qualität und Anwendbarkeit der generierten Antworten erheblich beeinflussen.

Was ist eine Systemnachricht?

Die Systemnachricht ist ein Teil des Prompts, der speziell dazu dient, das KI-Modell zu „instruieren“. Sie bietet spezifische Informationen oder Anweisungen, wie das KI-Modell auf den Prompt reagieren soll. Dabei kann es sich um Anweisungen zur Struktur der Antwort, zur Verwendung bestimmter Informationen oder zur Berücksichtigung bestimmter Kontextelemente handeln.

Warum ist die Systemnachricht wichtig?

Die Systemnachricht spielt eine entscheidende Rolle bei der Führung des KI-Modells und der Sicherstellung, dass es die gewünschten Antworten liefert. Eine gut formulierte Systemnachricht kann das KI-Modell dazu anleiten, relevante und nützliche Antworten zu generieren, während eine unklare oder ungenaue Systemnachricht zu irreführenden oder ungenauen Antworten führen kann.

Zum Beispiel kann eine Systemnachricht in einem Kundenservice-Chatbot das KI-Modell anweisen, nur Informationen zu liefern, die speziell auf die Frage des Kunden zugeschnitten sind, und allgemeine oder irrelevante Informationen zu vermeiden. Dies hilft dabei, sicherzustellen, dass das KI-Modell effektive und hilfreiche Antworten liefert, die den Kunden zufriedenstellen.

Wie wird die Systemnachricht im Prompt Engineering genutzt?

Im Kontext des Prompt Engineerings wird die Systemnachricht sorgfältig formuliert und strukturiert, um das KI-Modell effektiv zu leiten. Dies kann beinhalten:

- Die Definition spezifischer Anforderungen an die Struktur der Antwort.

- Die Bereitstellung von Anweisungen zur Nutzung bestimmter Informationen oder Ressourcen.

- Die Berücksichtigung von Kontextelementen, die für die Antwort relevant sein könnten.

Bei Coleida nutzen wir unsere Expertise in der Formulierung von Systemnachrichten, um unsere KI-Modelle zu effektiven und nützlichen Antworten zu führen. Durch die kontinuierliche Anpassung und Verbesserung unserer Systemnachrichten können wir die Leistung unserer KI-Modelle optimieren und sicherstellen, dass sie stets die gewünschten Ergebnisse liefern.

Der iterative Prozess des Prompt Engineerings

Prompt Engineering ist kein einmaliger Prozess, sondern vielmehr ein iterativer Zyklus, der ständige Anpassungen und Verbesserungen erfordert. Der iterative Prozess des Prompt Engineerings beinhaltet das Testen, Bewerten und Optimieren der Prompts, um sicherzustellen, dass die KI-Modelle die gewünschten Antworten liefern.

Phase 1

Erstellung und Testen der Prompts

Der erste Schritt im iterativen Prozess des Prompt Engineerings besteht darin, die ursprünglichen Prompts zu erstellen und zu testen. Dies beinhaltet die Formulierung der Prompts, die Einbindung in das KI-Modell und die Durchführung von ersten Tests, um zu sehen, wie das Modell auf die Prompts reagiert.

Phase 2

Auswertung der Antworten

Nachdem die Prompts getestet wurden, folgt die Auswertung der Antworten des KI-Modells. Hierbei wird beurteilt, ob die Antworten des Modells den Erwartungen entsprechen und ob sie relevant und nützlich sind. Diese Phase kann auch die Analyse der Leistung des Modells in Bezug auf verschiedene Metriken beinhalten, wie z.B. Genauigkeit, Relevanz oder Vollständigkeit der Antworten.

Phase 3

Optimierung der Prompts

Auf der Grundlage der Auswertung der Antworten werden die Prompts dann optimiert. Dies kann eine Überarbeitung der Formulierung der Prompts, die Anpassung der Anweisungen oder die Änderung der Struktur der Prompts beinhalten. Die optimierten Prompts werden dann erneut in das KI-Modell eingespeist und getestet.

Iteration des Prozesses

Dieser gesamte Prozess wird dann so lange wiederholt, bis die Antworten des KI-Modells den Erwartungen entsprechen und die gewünschten Ergebnisse liefern. Jeder Iterationsschritt liefert wertvolle Erkenntnisse, die zur kontinuierlichen Verbesserung der Prompts und der Leistung des KI-Modells beitragen.

Fazit

Prompt Engineering spielt eine entscheidende Rolle in der Entwicklung und Optimierung von Künstlicher Intelligenz. Durch die sorgfältige Formulierung und Strukturierung von Prompts können Entwickler KI-Modelle dazu bringen, relevante und nützliche Antworten zu liefern, die Benutzer bei der Erreichung ihrer Ziele unterstützen.

Die iterative Natur des Prompt Engineerings erlaubt es, stetig zu lernen und Verbesserungen vorzunehmen. Durch wiederholtes Testen, Bewerten und Optimieren der Prompts wird sichergestellt, dass die KI-Modelle immer die gewünschten Ergebnisse liefern.

Zusätzlich spielen Systemnachrichten eine wichtige Rolle im Prompt Engineering. Sie dienen als eine Art Anleitung für das KI-Modell und können die Qualität der generierten Antworten erheblich beeinflussen.

Haben Sie weitere Fragen zum Prompt Engineering oder möchten Sie mehr über unsere Arbeit erfahren? Zögern Sie nicht, uns zu kontaktieren. Unser Team von KI-Experten freut sich darauf, Ihnen weiterzuhelfen.